Claude adatfelhasználási politika: mit hoz a változás a beszélgetéseidre?

Gondolkodtál már rajta, mi történik a beszélgetéseiddel, ha a mesterséges intelligencia tanul tőled? A Claude adatfelhasználási politika most megváltozik, és ez a döntés benned is felvethet pár kérdést. Felhasználók százai számára ez a lehető leggyorsabb út az átláthatósághoz: opt-in, opt-out, és egy öt évre szóló adathordozó terv. Képzeld el, hogy a csevegéseid egyszerre személyesek és potenciális ültetett tananyagok egy új modell számára. De vajon mennyire érzi magát biztonságban a saját beszéded?

Mi változik a Claude adatfelhasználási politika tükrében?

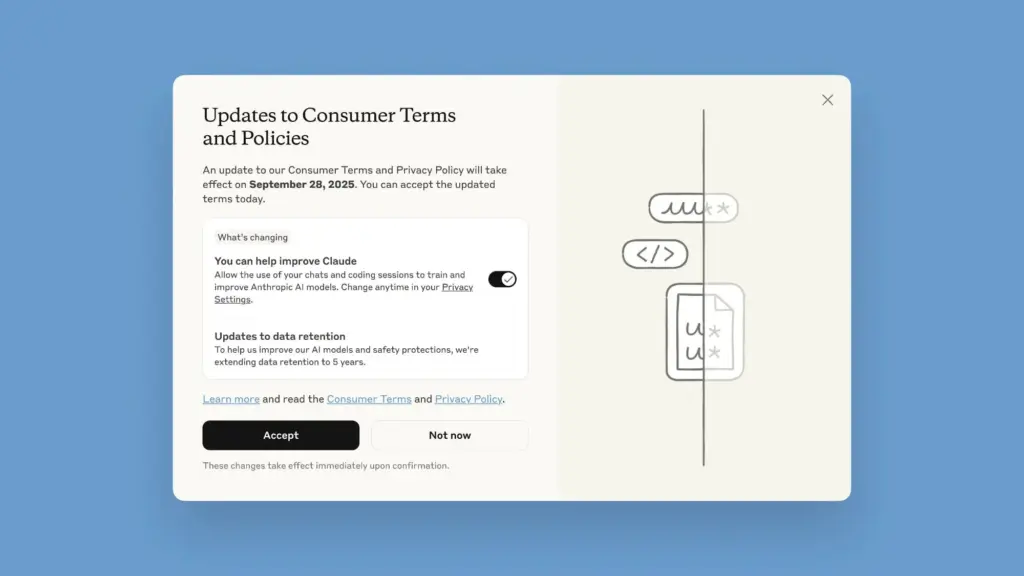

Az új irányelvek bevezetésekor minden felhasználó előtt egy felugró ablak jelenik meg. Itt dönthetsz: megengeded-e, hogy a beszélgetéseidet a Claude fejlesztésére és tréningjére használják? Az “You can help improve Claude” kapcsoló be- vagy kikapcsolhatja ezt. Az opt-in vagy opt-out döntés a szeptember 28-ig kötelező, hogy továbbra is használhasd Claude-ot az aktuális beszélgetéseiddel.

Miért fontos ez a kettősség? Mert ha engedélyezed, a beszélgetések bekerülnek a modell továbbfejlesztésére. Ha nem, akkor nem kerülnek be, és a jövőbeli képességek kevésbé „ütőek” lehetnek. A lényeg: te vagy a döntő tényező, hogy mi legyen a te adataiddal.

Az új rendszer kiterjeszti az adatok megőrzését is. Ha opt-in-t választasz, az adataid 5 évig maradnak a rendszerben, hogy még jobban megértsék a használati mintákat és fejlődjenek a modellek. Ez a hosszabb megőrzési idő adatvédelmi és biztonsági kockázatokkal is járhat, ezért fontos, hogy figyelj a saját preferenciáidra.

Hogyan érinti ez a mindennapi felhasználót?

Ha a felhasználói felületet veszed alapul, a változás leginkább abban nyilvánul meg, hogy az adatcselekmények menedzselése kiemelten a te kezedbe kerül. Az opt-out lehetőséggel visszakerülhetnek a chat-áramlatok, ha nem szeretnéd, hogy a beszélgetéseid tanítsák Claude tudását. A felhasználók, akik a Claude Free, Pro és Max tervek valamelyikét használják, érintettek lehetnek, de a Claude for Work vagy Claude for Education csak a vállalati/ oktatási megállapodások alatt marad meg a régi feltételek szerint.

A gyakorlatban ez azt jelenti, hogy ha opt-in-t választasz, az adataid 5 évig maradnak a vállalatnál, és ha később törlöd a beszélgetéseidet vagy visszalépsz, a korábbi beszélgetéseket nem lehet a későbbiekben felhasználni a modell tréningjéhez. A törlések esetén: a beszélgetések egy részét később nem használják fel a tréninghez.

És mi a helyzet a harmadik fél adataival? A hivatalos közlemény szerint nem adnak ki információt harmadik feleknek, és egy „együttműködés a szelektív adathalmazokkal” eszközökkel szűrik a szenzitív adatokat. A valóságban ez azért jó hír, mert kevesebb esély van arra, hogy egy véletlenül begyűjtött kulcsfontosságú adathalmaz kikerüljön a keretek közül.

<h2 Miért érdemes foglalkozni vele? Előnyök és árnyoldalak

Az egyik legnagyobb előny, hogy a vállalat nagyobb valószínűséggel tud majd ütős újításokat bevetni. Ha szívesen használod a legújabb modelleket, a ütős újítások gyorsabban érkezhetnek, hiszen a tréningadatokból sokat lehet tanulni. Ugyanakkor a hátrány, hogy a beszélgetéseid veszélybe kerülhetnek, ha személyes vagy érzékeny információkat osztasz meg.

„De én mit tehetek?” – kérdezed. Először is, döntsd el, mit szeretnél megosztani, és használd a beállításokat okosan. Ha úgy érzed, a beszélgetéseid nem tartalmaznak olyan adatokat, amelyeket szívesen tennél a modell tréningjéhez, egyszerűen válaszd az opt-outot. Másodszor: használj példákat, szövegkörnyezetet, amelyik kimondottan nem kötődik személyes adatokhoz.

És ha mégis opt-in-t választasz, készítsd előmagad a következőkre: az adataid megőrzése öt évig tart, és ez idő alatt a modell fejlesztése érdekében felhasználják az interakcióidat. A törlés után az adatok nem kerülnek vissza a tréningbe, de a 30 napos mentési időszak továbbra is érvényes lehet, ha valamilyen hiba történik.

<h2 Hogyan használd okosan a beállításokat? Gyakorlati tippek

Először is nézd meg Claude beállításait: Settings → Privacy. Innen tudod állítani, hogy engedélyezed-e a „Help improve Claude” lehetőséget. Ha csak kíváncsi vagy, hogyan működik a rendszer, kísérletezz egy olyan beszélgetéssel, amelyben nem osztasz meg érzékeny információkat.

Másodszor, fontold meg az adatvédelmi beállítás Claude használatát a mindennapi munka során. Ha például kód vagy dőlt stílusú vélemény kerül elő, ne feledd: a nyelvi modellnek is lehet más interpretációja, mint a tiéd. Ezzel elkerülheted a félreértéseket és a „lag” okozta bosszúságokat.

Végül: figyeld a frissítéseket. Az új irányelvek folyamatos finomítás alatt állnak, és lehet, hogy a következő hónapokban finomhangolások érkeznek az opt-in/opt-out folyamatoknál. A döntésed pedig mindig a te kezedben van.

<h2 Összehasonlítás és záró gondolat

Más AI-szolgáltatókhoz képest a Claude politikája egyértelmű és átlátható: döntesz te, mennyire osztod meg az adataidat, és meddig maradnak elérhetők a modellek tanításához. Ez a fajta nyitottság jó üzenet lehet, de hozzáad egy kis nyomást is: ha fontos számodra a magánszféra, érdemes aktívan beállítgatni a dolgokat, nem pedig vakon használni az új funkciókat.

Ha szerinted ez a téma csak technikai részlet, gondolj rá úgy, mint egy kényelmi százalékkal növelt személyre szabási lehetőségre. A jó kérdés azonban mindig ez: te mit szeretnél adni a jövő AI-jainak, és mi legyen belőled a tréning adathalmazban? A te döntésed alakítja a jövő Claude-ját. Tehát legyen a te kezedben a kontroll. És tegek, már csak egy kattintásra vagy attól, hogy eldöntsd: opt-in vagy opt-out.”

Discover more from Mobil Rank

Subscribe to get the latest posts sent to your email.